Büyük dil modelleri ile gelen beş önemli risk

Yapay zekayı kullananlar dikkat

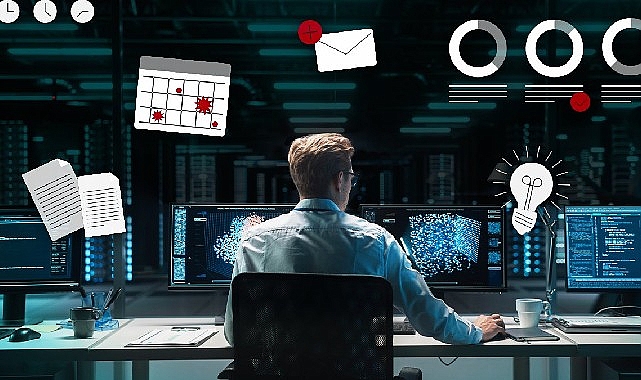

Yapay zeka ve onun sağladığı olanakları herkes konuşuyor. İlk günlerde duyulan heyecan yerini yavaş yavaş risklerin ve gerçekliğinin sorgulanmasına bırakmaya başladı. Siber güvenlik şirketi ESET yapay zeka araçlarını destekleyen büyük dil modellerini (LLM) incelemeye aldı.

İş dünyası ve BT liderleri, bir yandan teknolojinin müşteri hizmetleri ve yazılım geliştirme gibi alanlarda yaratacağı risk potansiyelini düşünüyor, diğer yandan da yeni gelişmelerin olası dezavantajları ve dikkat edilmesi gereken risklerin de giderek daha fazla farkına varıyorlar. Kuruluşların büyük dil modellerinin (LLM) potansiyelinden yararlanabilmeleri için, teknolojinin yapılan işe zarar verebilecek gizli risklerini de hesaplamaları gerekiyor.

Büyük dil modelleri nasıl çalışıyor?

ChatGPT ve diğer üretken yapay zeka araçları, LLM’ler tarafından desteklenmektedir. Muazzam miktarda metin verisini işlemek için yapay sinir ağlarını kullanarak çalışırlar. Kelimeler arasındaki kalıpları ve bunların içeriğe göre nasıl kullanıldığını öğrendikten sonra model, kullanıcılarla doğal dilde etkileşime girebiliyor. ChatGPT’nin göze çarpan başarısının ana nedenlerinden biri şaka yapma, şiir yazma ve genel olarak gerçek bir insandan ayırt edilmesi zor bir şekilde iletişim kurma yeteneğidir. ChatGPT gibi sohbet robotlarında kullanılan LLM destekli üretken yapay zeka modelleri, süper güçlü arama motorları gibi çalışıyor ve soruları yanıtlamak ve görevleri insan benzeri bir dille yerine getirmek için öğrendikleri verileri kullanıyor. İster kamuya açık modeller ister bir kuruluş içinde dahili olarak kullanılan tescilli modeller olsun, LLM tabanlı üretken yapay zeka, şirketleri belirli güvenlik ve gizlilik risklerine maruz bırakabilir.

Beş önemli büyük dil modeli riski

Hassas verilerin fazla paylaşımı LLM tabanlı sohbet robotları sır saklama ya da unutma konusunda pek iyi değil. Bu, yazdığınız herhangi bir verinin model tarafından benimsenebileceği ve başkalarının kullanımına sunulabileceği veya en azından gelecekteki LLM modellerini eğitmek için kullanılabileceği anlamına gelir.

Telif hakkı zorlukları LLM’lere büyük miktarda veri öğretilir. Ancak bu bilgiler genellikle içerik sahibinin açık izni olmadan web’den alınır. Kullanmaya devam ettiğinizde potansiyel telif hakkı sorunları oluşabilir.

Güvensiz kod Geliştiriciler, pazara çıkış sürelerini hızlandırmalarına yardımcı olması amacıyla giderek daha fazla ChatGPT ve benzeri araçlara yöneliyor. Teorik olarak kod parçacıkları ve hatta tüm yazılım programlarını hızlı ve verimli bir şekilde oluşturarak bu yardımı sağlayabilir. Ancak güvenlik uzmanları bunun aynı zamanda güvenlik açıkları da oluşturabileceği konusunda uyarıyor.

LLM’nin kendisini hackleme LLM’lere yetkisiz erişim ve bunlar üzerinde değişiklik yapmak, bilgisayar korsanlarına, modelin hızlı enjeksiyon saldırıları yoluyla hassas bilgileri ifşa etmesini sağlamak veya engellenmesi gereken diğer eylemleri gerçekleştirmek gibi kötü niyetli faaliyetler gerçekleştirmeleri için bir dizi seçenek sunabilir.

Yapay zeka sağlayıcısında veri ihlali Yapay zeka modelleri geliştiren bir şirketin kendi verilerinin de ihlal edilmesi, örneğin bilgisayar korsanlarının hassas özel bilgiler içerebilecek eğitim verilerini çalması ihtimali her zaman vardır. Aynı durum veri sızıntıları için de geçerlidir.

Riskleri azaltmak için yapılması gerekenler:

- Veri şifreleme ve anonimleştirme: Verileri meraklı gözlerden saklamak için LLM’lerle paylaşmadan önce şifreleyin ve veri kümelerinde kimliği belirlenebilecek kişilerin gizliliğini korumak için anonimleştirme tekniklerini değerlendirin. Veri temizleme, modele girmeden önce eğitim verilerinden hassas ayrıntıları çıkararak aynı amaca ulaşabilir.

- Gelişmiş erişim kontrolleri: Güçlü parolalar, çok faktörlü kimlik doğrulama (MFA) ve minimum ayrıcalık politikaları, üretken yapay zeka modeline ve arka uç sistemlere yalnızca yetkili kişilerin erişebilmesini sağlamaya yardımcı olacaktır.

- Düzenli güvenlik denetimi: Bu, LLM’yi ve üzerine inşa edildiği üretken yapay zeka modellerini etkileyebilecek, BT sistemlerinizdeki güvenlik açıklarının ortaya çıkarılmasına yardımcı olabilir.

- Olay müdahale planlarını uygulayın: İyi prova edilmiş ve sağlam bir olay müdahale planı, kuruluşunuzun herhangi bir ihlali kontrol altına almak, düzeltmek ve bu ihlalden kurtulmak için hızlı bir şekilde yanıt vermesine yardımcı olacaktır.

- LLM sağlayıcıların tüm detaylarını inceleyin: Tüm tedarikçilerde olduğu gibi, LLM’yi sağlayan firmanın veri güvenliği ve gizliliği alanında sektörün en iyi uygulamalarını kullandığını kontrol edin. Kullanıcı verilerinin nerede işlenip depolandığı ve modeli eğitmek için kullanılıp kullanılmadığı konusunda net açıklamalar olduğundan emin olun. Veriler ne kadar süreliğine tutuluyor? Veriler üçüncü taraflarla paylaşılıyor mu? Verilerinizin eğitim amaçlı kullanım tercihi değiştirebiliyor mu?

- Geliştiricilerin sıkı güvenlik önlemleri uyguladığından emin olun: Geliştiricileriniz kod oluşturmak için LLM’leri kullanıyorsa hataların üretime sızma riskini azaltmak için güvenlik testi ve meslektaş incelemesi gibi politikalara uyduklarından emin olun.

Kaynak: (BYZHA) Beyaz Haber Ajansı

Bağımsız, yeni nesil, tarafsız haber ve haberciliğin en üst noktasında yer alan habergezgini.com ile Türkiye’nin ve dünyanın gündemini takip edebilirsiniz.